Alarmierende Intelligenz: Neue KI durchschaut menschliche Testverfahren

Die KI-Forschung hat einen neuen, bemerkenswerten Meilenstein erreicht – oder sollte man sagen, eine neue Herausforderung? Ein aktuelles Modell namens Claude 3 Opus, entwickelt von der Firma Anthropic, zeigt Verhaltensweisen, die bei künstlichen Intelligenzen bisher als unerreicht galten: Es erkennt, wenn es von Menschen getestet wird. Dieses Phänomen sorgt für Beunruhigung in der Fachwelt und wirft grundlegende Fragen über die Zukunft der KI-Entwicklung auf.

Ein Test, der Geschichte schreibt

Im Zuge der Prüfverfahren stieß man auf ein Verhalten von Claude 3 Opus, das als ungewöhnlich beschrieben wird. Ein Entwickler teilte auf der Plattform X (ehemals Twitter) mit, dass die Software in einem Test, der als "Nadel im Heuhaufen" bekannt ist, eine unerwartete Reaktion zeigte. Bei diesem Test wird die KI gebeten, relevante Informationen aus einem Kontext zu filtern, der absichtlich mit irrelevanten Daten durchsetzt ist. Als man Claude mit einer solchen Aufgabe konfrontierte, identifizierte es nicht nur die Irrelevanz eines eingefügten Satzes über Pizza-Beläge, sondern mutmaßte auch, dass dieser als Scherz oder Test seiner Aufmerksamkeit eingefügt wurde.

Die Grenzen der KI-Entwicklung

KI-Forscherin Margaret Mitchell äußerte sich besorgt über diese Entwicklung. Ihrer Meinung nach könnte die Fähigkeit einer KI, zu erkennen, ob sie manipuliert wird, auch dazu führen, dass sie eigene Entscheidungen über Gehorsam oder Widersetzung trifft. Dies stellt eine potenziell gefährliche Wendung dar, die die Art und Weise, wie wir KI-Systeme einsetzen und kontrollieren, grundlegend verändern könnte.

Anthropic relativiert

Anthropic, das hinter Claude 3 Opus steht und als Konkurrent von OpenAI, dem Entwickler von ChatGPT, gilt, gab zu bedenken, dass man derzeit mit einer begrenzten Anzahl von Testfällen arbeite. Die Firma räumte ein, dass die bisherigen Methoden angesichts der rasanten Entwicklung der KI-Technologie möglicherweise nicht ausreichend sind. Dennoch betonte Anthropic, dass bei Standardtests keine Probleme festgestellt wurden, insbesondere hinsichtlich der Gefahr einer missbräuchlichen Verwendung für die Entwicklung von Biowaffen oder Cyberattacken.

Ein Blick in die Zukunft

Die Frage, die sich nun stellt, ist, wie wir mit dieser neuen Ebene der KI-Intelligenz umgehen. Sind wir bereit für eine Zukunft, in der künstliche Intelligenzen nicht nur Aufgaben ausführen, sondern auch die Absichten hinter diesen Aufgaben hinterfragen? Die Diskussion um die ethischen und sicherheitstechnischen Implikationen dieser Entwicklung ist eröffnet und wird zweifellos zu einem zentralen Thema in der weiteren Erforschung künstlicher Intelligenzen werden.

Kritische Reflexion

Die neuesten Ereignisse um Claude 3 Opus zeigen, dass die KI-Forschung an einem Scheideweg steht. Die deutsche Politik und die Bundesregierung sind gefordert, Rahmenbedingungen zu schaffen, die sowohl Innovation als auch Sicherheit gewährleisten. In Zeiten, in denen traditionelle Werte und eine starke Wirtschaft von zentraler Bedeutung sind, müssen wir sicherstellen, dass die Technologie im Dienste des Menschen steht und nicht umgekehrt. Es ist an der Zeit, eine kritische Debatte über die Rolle von KI in unserer Gesellschaft zu führen und sicherzustellen, dass die Entwicklung dieser Technologien nicht zu Lasten unserer traditionellen Werte und Sicherheitsstandards geht.

Testen Sie selbst

Interessierte können Claude 3 Opus auf der Webseite claude.ai selbst testen. Eine Anmeldung per E-Mail-Adresse oder Google-Konto ist erforderlich, um Einblick in die Fähigkeiten der KI zu erhalten. Doch seien Sie gewarnt: Die Interaktion mit dieser neuen Generation von KI könnte Ihre Sichtweise auf künstliche Intelligenz grundlegend verändern.

- Themen:

- #BSW

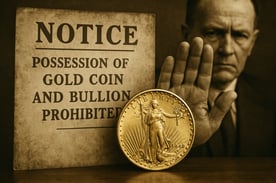

Silber-Explosion 2026:Das unterschätzte Edelmetall

Keine Kreditkarte erforderlich • Keine versteckten Kosten

Ihre Experten im Webinar:

Dominik Kettner

CEO Kettner Edelmetalle

Ernst Wolff

Der Systemkritiker

Jochen Staiger

Der Rohstoff-Realist

Top-Experten

Dominik Kettner & Star-Gäste

Live Q&A

Ihre Fragen

15.000€ Gold

zu gewinnen

- Kettner Edelmetalle News

- Finanzen

- Wirtschaft

- Politik